![]() Битыми ссылками принято называть ссылки на сайте, которые по каким-то причинам перестали работать, вследствие чего, это не очень хорошо может повлиять на восприятие вашего сайта пользователями, не говоря уже о поисковых системах. Сегодня я решил рассказать вам про один интересный инструмент, из серии простой в использовании, но крайне полезный.

Битыми ссылками принято называть ссылки на сайте, которые по каким-то причинам перестали работать, вследствие чего, это не очень хорошо может повлиять на восприятие вашего сайта пользователями, не говоря уже о поисковых системах. Сегодня я решил рассказать вам про один интересный инструмент, из серии простой в использовании, но крайне полезный.

Xenu Links – это программа, которая пробегается по указанному ресурсу, собирая ссылки на страницах, и выводя их в общий лог, помечая их конкретным статусом. Инструмент может оказаться весьма полезным для владельцев сайта, оптимизаторов, в общем, всех тех, кому не безразлично наличие битых ссылок у себя сайте. Посредством этой программы, вы можете выявить нерабочие ссылки у себя на сайте, просмотреть мета теги каждой из ссылок, либо их отсутствие, чтобы потом принимать какие-то решения.

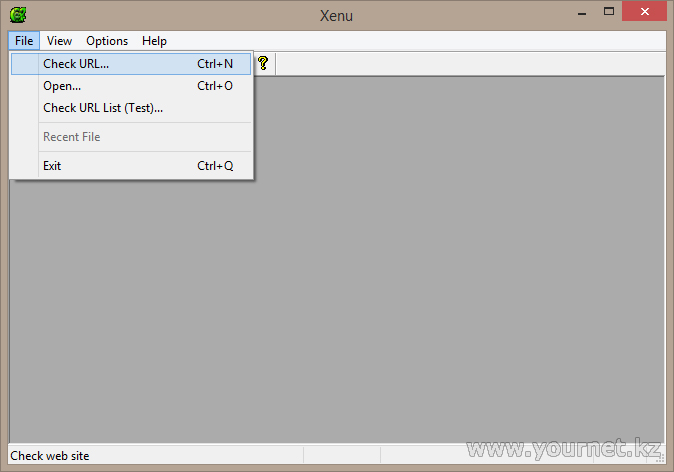

Первым делом, перед тем как что-то сканировать, нам необходимо задать минимум настроек, а именно указать адрес ресурса который собрались сканировать, а так же дополнительные параметры. Давайте запустим программу, и попробуем задать настройки для нашего сайта. Открыть форму настроек адреса ресурса можно с помощью комбинации клавиш Ctrl+N, либо через главное меню программы:

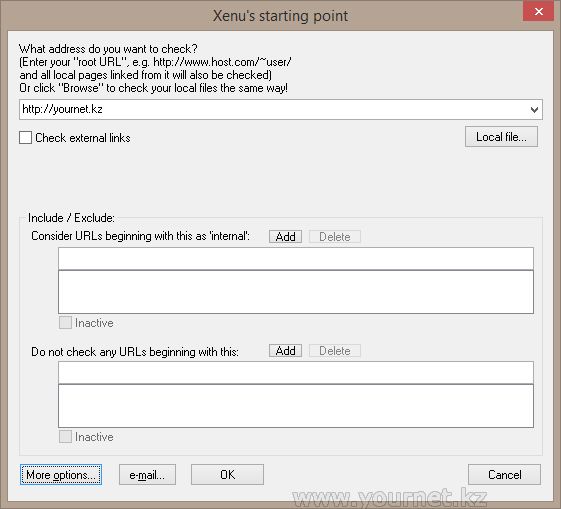

Откроется окно настроек, в котором вам следует указать ваш URL адрес ресурса. Это окно можно назвать стартовой точкой, если вы заметили, заголовок окна так же говорит об этом. По умолчанию программа сканирует и находит ссылки только в пределах ресурса указанного вами, однако если есть необходимость проверять и внешние ссылки, то поставив галочку на пункте Check external links (проверять внешние ссылки), сканер будет так же запрашивать и внешние ссылки.

Local file – позволяет открывать файлы для проверки с вашего компьютера, Include / Exclude – тут добавляются либо исключаются ссылки для сканирования. Не будем затягивать с описанием всех параметров, а рассмотрим лишь те, чтобы уже можно было как-то начать сканировать. Про всё вы можете почитать в мануалах к программе. Теперь откроем окно дополнительных параметров, жмем на кнопку More options, появляется такое окно:

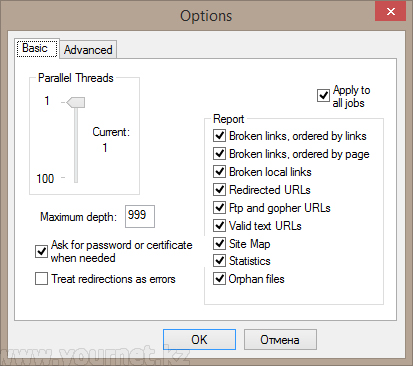

Parallel Threads – параметр, который указывает количество одновременных запросов при сканировании. Особо актуален в случае если ваш ресурс не очень быстрый, чтобы не уложить его основательно спать, следует выставить более подходящее значение, чтобы сканирование прошло более или менее удачно.

Maximum depth — параметр, который указывает максимальное количество загружаемых страниц. Увеличьте это число, если их большое количество, однако лимит на одновременное скачивание лучше поставить поменьше.

Всё остальное я оставлю как есть по умолчанию, давайте уже приступим к сканированию, чтобы не тянуть резину, жмем на кнопки OK, и процесс начинается.

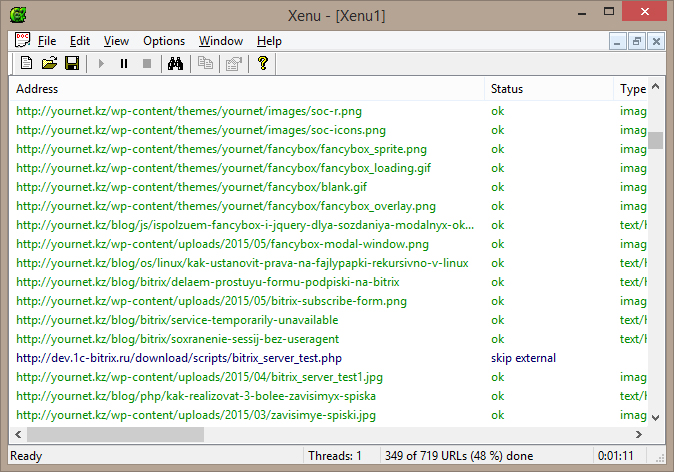

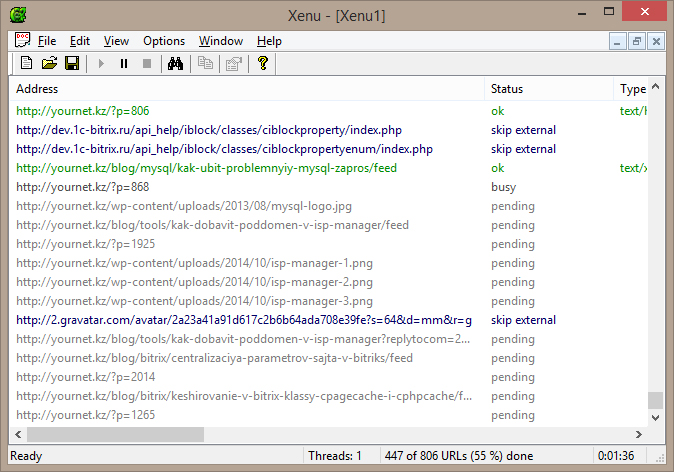

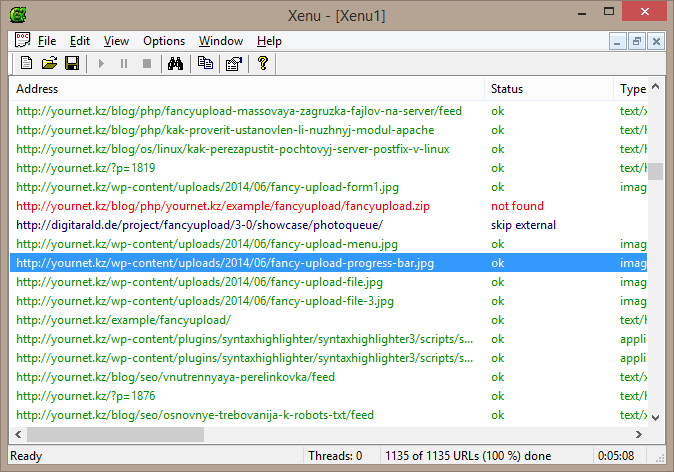

Как можно наблюдать все данные при сканировании выводятся в виде списка. Каждая запись представляет собой конкретную ссылку. Текущий статус конкретной ссылки так же определяет её цвет в списке. Все найденные внутренние ссылки изначально помечаются серым цветом, до того момента как программа не пыталась запросить её. Статус у этих ссылок имеет значение pending. Мы выставили параметр skip external links, теперь все внешние ссылки в нашем списке отмечены синим цветом и имеют статус skip external. Статусы сканирования, которые наблюдаются в моем примере: pending – ссылка ждет своей очереди сканирования, skip external – пропуск внешней ссылки, busy – в процессе сканирования. В общем, отмечу, что статусов сканирования значительно больше, и проблемные ссылки в конечном итоге отмечаются красным цветом, вы это заметите сразу:

Кроме всего этого программа может быть использована для комплексного анализа страниц сайта, к примеру, можно выявлять страницы которые долго грузится, определение кодировки страниц, количество ссылок на странице, уровень вложенности страницы и т.д.